TensorFlow Fold 教程:处理动态/可变长度输入的利器

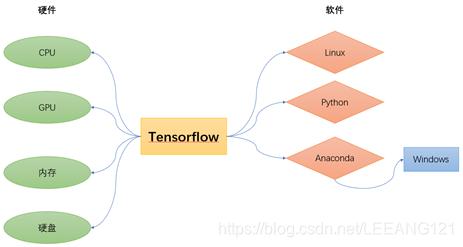

什么是 TensorFlow Fold?

TensorFlow Fold 是一个由 Google Research 开发的 TensorFlow 库,它的核心目标是解决 TensorFlow 在处理动态计算图时的一个主要痛点:性能开销。

问题背景:

在标准的 TensorFlow 中,一个静态计算图一旦定义好,其形状和结构就固定了,在许多现实世界的任务中,我们处理的输入是可变长度的,

- 自然语言处理: 不同句子的长度不同。

- 计算机视觉: 一张图片中物体的数量不同。

- 图神经网络: 图中节点的邻居数量不同。

为了处理这种可变长度输入,传统的做法是使用 tf.while_loop 或 tf.map_fn,这些操作符虽然灵活,但它们会破坏 TensorFlow 的计算图优化(如融合、内存规划等),导致显著的性能下降,尤其是在 GPU 上。

TensorFlow Fold 的解决方案:

TF Fold 的核心思想是延迟批处理,它允许你为每个单独的样本定义一个计算逻辑,然后在内部将这些计算图进行批处理,最后生成一个优化的、静态的计算图来高效地处理整个批次。

简单比喻:

- 标准 TF (低效方式): 像一个流水线,你必须为所有输入(无论长短)准备一个“标准尺寸”的盒子,短句子需要填充,长句子需要截断,流水线对每个盒子里的内容进行单独处理,效率低下。

- TensorFlow Fold (高效方式): 像一个高度智能的工厂,你告诉工厂如何处理一个“零件”(一个句子),工厂会接收一批零件,然后根据每个零件的实际大小和形状,智能地安排最优的加工流程,将多个相似的处理步骤合并,从而大大提高整体效率。

核心概念:Batchifier 和 Combiner

要理解 TF Fold,必须掌握两个核心概念:

-

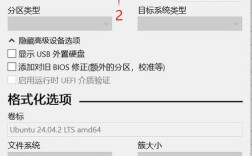

Batchifier(批处理器): (图片来源网络,侵删)

(图片来源网络,侵删)- 作用: 将一个单独的、动态的计算图(称为“模块”或“module”)转换成一个静态的、可批处理的计算图。

- 工作原理: 它接收一个模块实例,并返回一个张量,这个张量代表了整个批次的计算结果,TF Fold 内部会自动处理不同大小输入的拼接和分割。

-

Combiner(合并器):- 作用: 定义如何将多个独立的模块实例合并成一个单一的、批处理的计算图。

- 工作原理: 它接收一个模块实例列表,并返回一个合并后的模块实例,这个合并后的实例在运行时可以高效地处理整个批次。

工作流程:

- 你定义一个

Module,它封装了处理单个样本的逻辑。 - 你使用

Batchifier将这个Module转换成一个可以处理批次的Module。 - 你将一个可变长度的数据集(一个

tf.data.Dataset)喂给这个批处理后的Module。 - TF Fold 内部使用

Combiner来动态地组合这些计算图,最终生成一个高度优化的静态图进行执行。

安装

TensorFlow Fold 不是一个标准的 TensorFlow 包,你需要单独安装。

pip install tensorflow-fold

第一个例子:处理可变长度的矩阵

让我们从一个简单的例子开始,这个例子展示了 TF Fold 最核心的能力:处理不同形状的输入。

假设我们有一个批次的数据,每个数据是一个不同行数的矩阵,我们的任务是对每一行进行求和。

传统方法(使用 tf.map_fn):

import tensorflow as tf

# 输入: 一个包含3个不同形状矩阵的列表

# batch = [

# [[1, 2], [3, 4]], # 2x2

# [[5, 6, 7]], # 1x3

# [[8, 9], [10, 11], [12, 13]] # 3x2

# ]

# 在实际使用中,这通常来自一个 tf.data.Dataset

batch = [

tf.constant([[1, 2], [3, 4]]),

tf.constant([[5, 6, 7]]),

tf.constant([[8, 9], [10, 11], [12, 13]])

]

# 使用 map_fn 对每个矩阵的每一行求和

# fn 是一个对单个行进行操作的函数

result = tf.map_fn(lambda matrix: tf.reduce_sum(matrix, axis=1), batch, dtype=tf.int32)

print("传统 map_fn 结果:")

print(result.numpy())

# 输出:

# [[ 3 7]

# [18]

# [17 21 25]]

map_fn 虽然能工作,但效率不高。

TensorFlow Fold 方法:

现在我们用 TF Fold 来实现同样的功能。

import tensorflow as tf

import tensorflow_fold as td # 通常使用 td 作为别名

# 1. 定义处理单个样本的 Module

class RowSumModule(td.Module):

def __init__(self):

super().__init__()

def forward(self, tensor):

# 这个 forward 方法定义了如何处理一个单独的矩阵

# tensor 的形状是 [num_rows, num_cols]

return tf.reduce_sum(tensor, axis=1)

# 2. 准备输入数据 (与上面相同)

# 在实际应用中,你会使用 tf.data.Dataset.from_generator

# 这里为了演示,我们直接使用 Python 列表

# TF Fold 的 Batchifier 通常期望一个 tf.data.Dataset

dataset = tf.data.Dataset.from_generator(

lambda: [

tf.constant([[1, 2], [3, 4]]),

tf.constant([[5, 6, 7]]),

tf.constant([[8, 9], [10, 11], [12, 13]])

],

output_signature=tf.TensorSpec(shape=(None, None), dtype=tf.int32)

)

# 3. 创建 Module 实例

row_sum_module = RowSumModule()

# 4. 使用 Batchifier 进行批处理

# td.Batchifier 是最常用的批处理器,它内部会处理所有复杂的逻辑

batched_module = td.Batchifier(row_sum_module)

# 5. 运行批处理后的模块

# 直接将 dataset 传给 batched_module 即可

# 它会自动处理批次和可变长度

folded_result = batched_module(dataset)

print("\nTensorFlow Fold 结果:")

print(folded_result.numpy())

# 输出:

# [[ 3 7]

# [18]

# [17 21 25]]

代码解读:

RowSumModule(td.Module): 我们创建了一个继承自td.Module的类,在这个类中,forward方法定义了处理单个样本的逻辑,这里就是tf.reduce_sum(tensor, axis=1)。dataset: 我们创建了一个tf.data.Dataset,这是 TF Fold 推荐的数据输入方式,注意,每个元素的形状是(None, None),表示行数和列数都是可变的。td.Batchifier(row_sum_module): 这是关键一步。Batchifier将我们的RowSumModule(一个处理单个样本的模块)包装成了一个可以高效处理整个批次的模块。batched_module(dataset): 我们将数据集直接传给批处理后的模块,TF Fold 内部的Combiner会接管一切,将多个动态计算图智能地合并成一个高效的静态图进行计算。

进阶例子:在文本分类中的应用

这个例子更贴近实际应用,展示了如何将 TF Fold 与嵌入层和循环神经网络结合。

任务: 对句子进行情感分析,输入是不同长度的句子(单词ID序列)。

import tensorflow as tf

import tensorflow_fold as td

import numpy as np

# 1. 定义一个更复杂的 Module

class TextClassifierModule(td.Module):

def __init__(self, vocab_size, embedding_dim, rnn_units, num_classes):

super().__init__()

self.embedding = tf.keras.layers.Embedding(vocab_size, embedding_dim)

self.rnn = tf.keras.layers.GRU(rnn_units)

self.classifier = tf.keras.layers.Dense(num_classes)

def forward(self, sentence_ids):

# sentence_ids 的形状是 [batch_size_in_this_example, sequence_length]

# 注意:这里的 batch_size_in_this_example 是 1,因为 Batchifier 一次处理一个样本

x = self.embedding(sentence_ids) # -> [seq_len, embedding_dim]

x = self.rnn(x) # -> [rnn_units]

logits = self.classifier(x) # -> [num_classes]

return logits

# 2. 准备模拟数据

# 假设我们有以下句子(已转换为ID)

# "I love this" -> [10, 20, 30]

# "This is bad" -> [30, 40, 50, 60]

# "Good" -> [70]

sentences_data = [

tf.constant([[10, 20, 30]]),

tf.constant([[30, 40, 50, 60]]),

tf.constant([[70]])

]

dataset = tf.data.Dataset.from_generator(

lambda: sentences_data,

output_signature=tf.TensorSpec(shape=(None, None), dtype=tf.int32)

)

# 3. 创建并批处理 Module

VOCAB_SIZE = 100

EMBEDDING_DIM = 16

RNN_UNITS = 32

NUM_CLASSES = 2

classifier_module = TextClassifierModule(VOCAB_SIZE, EMBEDDING_DIM, RNN_UNITS, NUM_CLASSES)

batched_classifier = td.Batchifier(classifier_module)

# 4. 运行

logits = batched_classifier(dataset)

print("\n文本分类 logits:")

print(logits.numpy())

# 输出形状会是 [3, 2],因为我们有3个句子,每个句子输出2个分类的logits

# logits 的值每次运行都会不同,因为模型权重是随机初始化的

在这个例子中,forward 方法接收一个形状为 [1, seq_len] 的张量(因为 Batchifier 一次处理一个样本)。Embedding 层可以处理任意长度的序列,GRU 也可以处理任意长度的输入。Batchifier 确保了即使每个句子的 seq_len 不同,整个计算过程仍然高效。

优点与缺点

优点:

- 高性能: 通过延迟批处理和图合并,显著提升了可变长度数据在 GPU 上的训练和推理速度。

- 灵活性: 可以像写普通 Python 函数一样定义模型逻辑,无需担心静态图的形状限制。

- 易于集成: 可以与现有的

tf.data.Dataset和 Keras 层无缝结合。 - 自动处理: 自动处理了填充、掩码、动态形状等复杂问题。

缺点与注意事项:

- 学习曲线: 相比标准 TensorFlow,引入了新的概念(

Module,Batchifier),需要一定的学习成本。 - 调试困难: 由于涉及动态图到静态图的转换,调试问题可能比标准 TF 更具挑战性。

- 社区与文档: 相比 TensorFlow 本身,社区较小,官方文档和示例也相对较少。

- TF 2.x 兼容性: 虽然 TF Fold 支持 TF 2.x,但它的设计理念更偏向 TF 1.x 的“定义-运行”图模式,在使用

tf.function时需要格外小心。

总结与建议

TensorFlow Fold 是一个功能强大且专业的工具,特别适合以下场景:

- 研究型项目: 当你需要快速实现和测试处理可变长度数据的新模型架构时。

- 生产环境中的性能瓶颈: 如果你已经确定某个处理可变长度数据的模块是性能瓶颈,TF Fold 是一个极佳的优化方案。

- 图神经网络、NLP、CV 等领域: 这些领域天然存在大量可变长度的数据。

给初学者的建议:

- 先学标准 TensorFlow: 在完全掌握标准 TensorFlow(特别是

tf.data和 Keras)之前,不要急于学习 TF Fold。 - 从简单例子开始: 像我们上面的第一个例子一样,先理解

Module和Batchifier是如何协同工作的。 - 明确需求: 只有当你确实遇到了可变长度输入导致的性能问题时,才考虑引入 TF Fold,对于大多数简单的 NLP 任务,标准的 Keras +

tf.data+padding/masking已经足够高效。

TensorFlow Fold 是 TensorFlow 生态中一个不可或缺的补充,它完美地填补了静态图高效性和动态图灵活性之间的鸿沟。